强迫模型自我争论,递归思考版CoT热度飙升!网友:这不就是大多数推理模型的套路吗?

强迫模型自我争论,递归思考版CoT热度飙升!网友:这不就是大多数推理模型的套路吗?递归思考 + 自我批判,CoRT 能带来 LLM 推理力的飞跃吗?

递归思考 + 自我批判,CoRT 能带来 LLM 推理力的飞跃吗?

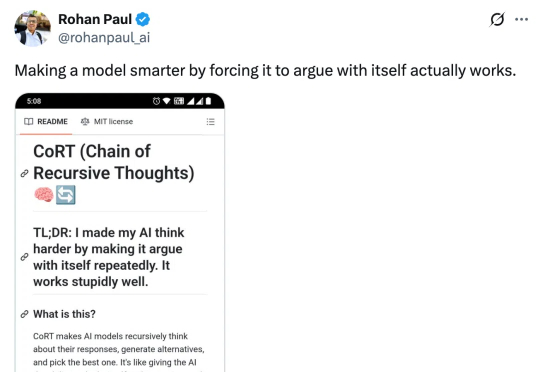

Mixture-of-Experts(MoE)在推理时仅激活每个 token 所需的一小部分专家,凭借其稀疏激活的特点,已成为当前 LLM 中的主流架构。然而,MoE 虽然显著降低了推理时的计算量,但整体参数规模依然大于同等性能的 Dense 模型,因此在显存资源极为受限的端侧部署场景中,仍然面临较大挑战。

该研究对 LLM 常见的失败模式贪婪性、频率偏差和知 - 行差距,进行了深入研究。

这篇论文包含了当前 LLM 的许多要素,十年后的今天或许仍值得一读。

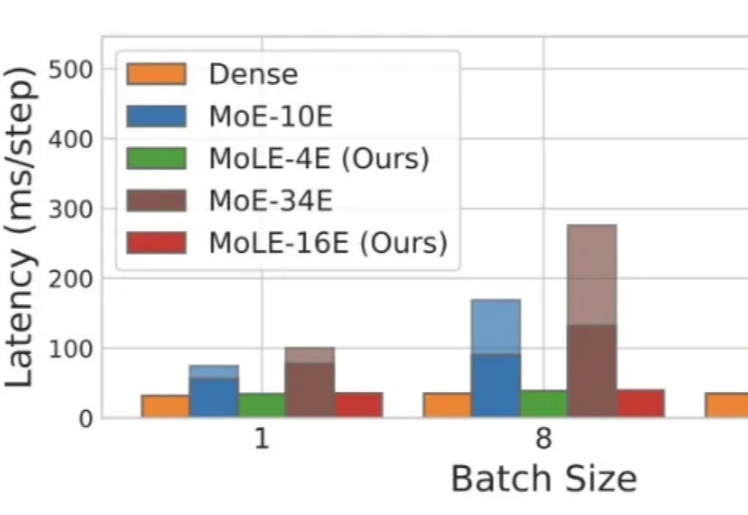

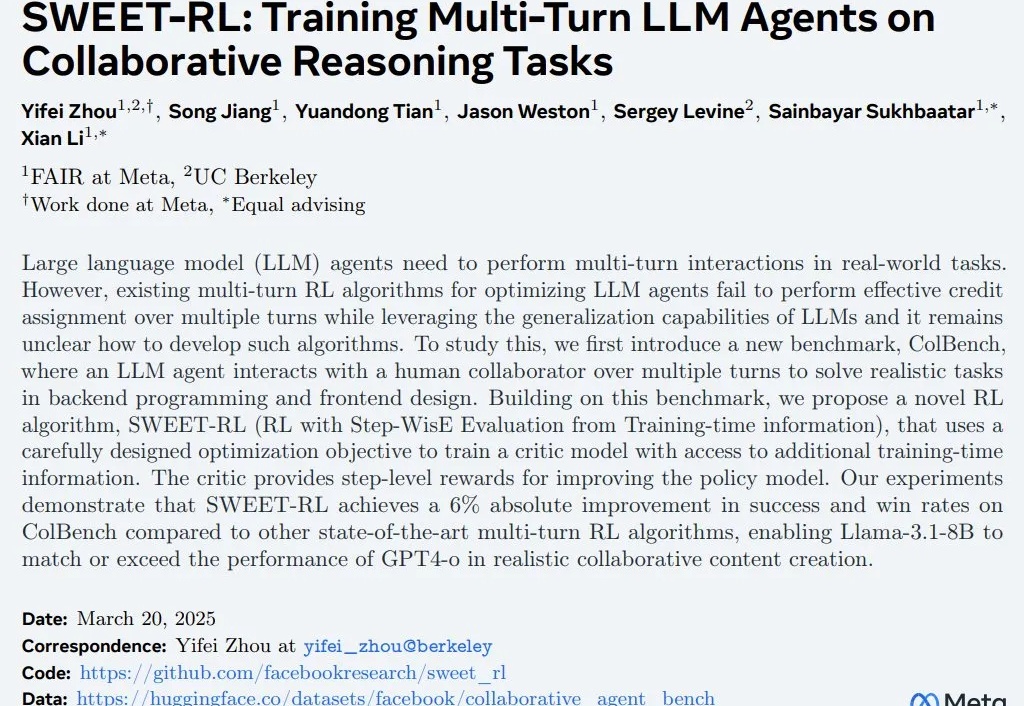

现如今,微调和强化学习等后训练技术已经成为提升 LLM 能力的重要关键。

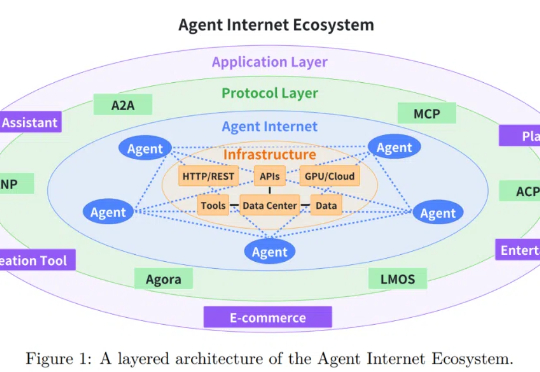

随着大语言模型 (LLM) 技术的迅猛发展,基于 LLM 的智能智能体在客户服务、内容创作、数据分析甚至医疗辅助等多个行业领域得到广泛应用。

RL + LLM 升级之路的四层阶梯。

近年来,大模型(Large Language Models, LLMs)在数学、编程等复杂任务上取得突破,OpenAI-o1、DeepSeek-R1 等推理大模型(Reasoning Large Language Models,RLLMs)表现尤为亮眼。但它们为何如此强大呢?

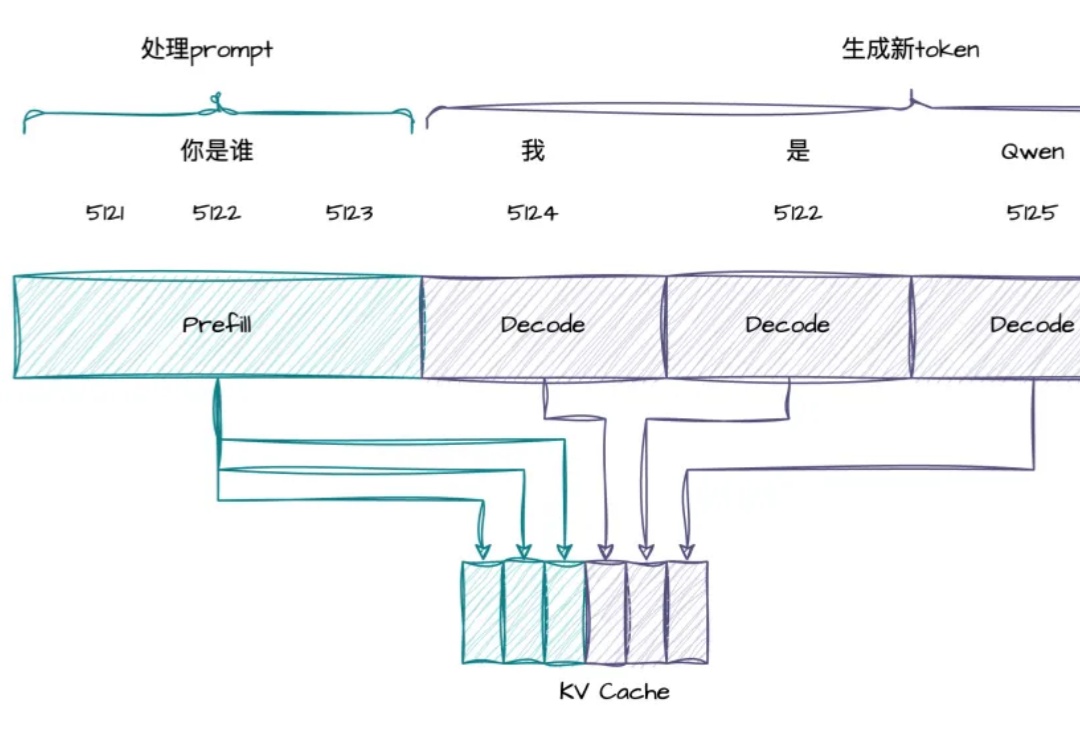

RTP-LLM 是阿里巴巴大模型预测团队开发的高性能 LLM 推理加速引擎。它在阿里巴巴集团内广泛应用,支撑着淘宝、天猫、高德、饿了么等核心业务部门的大模型推理需求。在 RTP-LLM 上,我们实现了一个通用的投机采样框架,支持多种投机采样方法,能够帮助业务有效降低推理延迟以及提升吞吐。

强化学习提升了 LLM 各方面的能力,而强化学习本身也在进化。